이전 포스팅에 이어 Tutorial 3을 진행하면서 pad, GSignal 등의 개념을 살펴봅니다. 이 튜토리얼에서는 demuxer를 이용해 하나의 source에서 오는 media를 2개의 출력으로 분리하는 예제를 보여주면서 pad와 GSignal 등의 개념을 소개합니다.

Basic tutorial 3: Dynamic pipelines

Basic tutorial 3: Dynamic pipelines Please port this tutorial to python! Please port this tutorial to javascript! Goal This tutorial shows the rest of the basic concepts required to use GStreamer, which allow building the pipeline "on the fly", as informat

gstreamer.freedesktop.org

#include <QCoreApplication>

#include <QDebug>

#include "gst/gst.h"

/* Structure to contain all our information, so we can pass it to callbacks */

typedef struct _CustomData {

GstElement *pipeline;

GstElement *source;

GstElement *convert;

GstElement *resample;

GstElement *sink;

} CustomData;

/* Handler for the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *pad, CustomData *data);

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

CustomData data;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

gboolean terminate = FALSE;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Create the elements */

data.source = gst_element_factory_make ("uridecodebin", "source");

data.convert = gst_element_factory_make ("audioconvert", "convert");

data.resample = gst_element_factory_make ("audioresample", "resample");

data.sink = gst_element_factory_make ("autoaudiosink", "sink");

/* Create the empty pipeline */

data.pipeline = gst_pipeline_new ("test-pipeline");

if (!data.pipeline || !data.source || !data.convert || !data.resample || !data.sink) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Build the pipeline. Note that we are NOT linking the source at this

* point. We will do it later. */

gst_bin_add_many (GST_BIN (data.pipeline), data.source, data.convert, data.resample, data.sink, NULL);

if (!gst_element_link_many (data.convert, data.resample, data.sink, NULL)) {

g_printerr ("Elements could not be linked.\n");

gst_object_unref (data.pipeline);

return -1;

}

/* Set the URI to play */

g_object_set (data.source, "uri", "https://www.freedesktop.org/software/gstreamer-sdk/data/media/sintel_trailer-480p.webm", NULL);

/* Connect to the pad-added signal */

g_signal_connect (data.source, "pad-added", G_CALLBACK (pad_added_handler), &data);

/* Start playing */

ret = gst_element_set_state (data.pipeline, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_printerr ("Unable to set the pipeline to the playing state.\n");

gst_object_unref (data.pipeline);

return -1;

}

/* Listen to the bus */

bus = gst_element_get_bus (data.pipeline);

do {

msg = gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

(GstMessageType) (GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS));

/* Parse message */

if (msg != NULL) {

GError *err;

gchar *debug_info;

switch (GST_MESSAGE_TYPE (msg)) {

case GST_MESSAGE_ERROR:

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n", GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n", debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

terminate = TRUE;

break;

case GST_MESSAGE_EOS:

g_print ("End-Of-Stream reached.\n");

terminate = TRUE;

break;

case GST_MESSAGE_STATE_CHANGED:

/* We are only interested in state-changed messages from the pipeline */

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data.pipeline)) {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

g_print ("Pipeline state changed from %s to %s:\n",

gst_element_state_get_name (old_state), gst_element_state_get_name (new_state));

}

break;

default:

/* We should not reach here */

g_printerr ("Unexpected message received.\n");

break;

}

gst_message_unref (msg);

}

} while (!terminate);

/* Free resources */

gst_object_unref (bus);

gst_element_set_state (data.pipeline, GST_STATE_NULL);

gst_object_unref (data.pipeline);

return a.exec();

}

/* This function will be called by the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *new_pad, CustomData *data) {

GstPad *sink_pad = gst_element_get_static_pad (data->convert, "sink");

GstPadLinkReturn ret;

GstCaps *new_pad_caps = NULL;

GstStructure *new_pad_struct = NULL;

const gchar *new_pad_type = NULL;

g_print ("Received new pad '%s' from '%s':\n", GST_PAD_NAME (new_pad), GST_ELEMENT_NAME (src));

/* If our converter is already linked, we have nothing to do here */

if (gst_pad_is_linked (sink_pad)) {

g_print ("We are already linked. Ignoring.\n");

goto exit;

}

/* Check the new pad's type */

new_pad_caps = gst_pad_get_current_caps (new_pad);

new_pad_struct = gst_caps_get_structure (new_pad_caps, 0);

new_pad_type = gst_structure_get_name (new_pad_struct);

if (!g_str_has_prefix (new_pad_type, "audio/x-raw")) {

g_print ("It has type '%s' which is not raw audio. Ignoring.\n", new_pad_type);

goto exit;

}

/* Attempt the link */

ret = gst_pad_link (new_pad, sink_pad);

if (GST_PAD_LINK_FAILED (ret)) {

g_print ("Type is '%s' but link failed.\n", new_pad_type);

} else {

g_print ("Link succeeded (type '%s').\n", new_pad_type);

}

exit:

/* Unreference the new pad's caps, if we got them */

if (new_pad_caps != NULL)

gst_caps_unref (new_pad_caps);

/* Unreference the sink pad */

gst_object_unref (sink_pad);

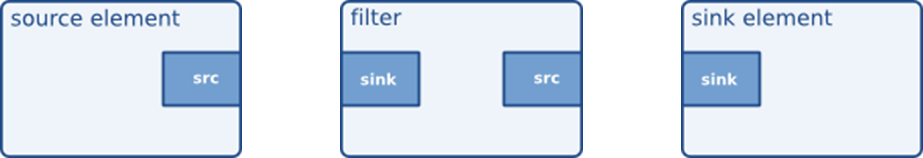

}elements들은 다른 elements와 통신할 때 pad라는 port를 이용합니다. 아래와 같이 source, sink는 그에 맞는 pad를 가지고 있으며 중간에 오는 filter나 기타 element들은 각자의 pad를 가지게 됩니다.

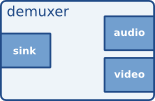

demuxer는 하나의 sink에서 온 데이터를 audio, video 2개의 source pad로 내보낼 수 있습니다.

source elements는 uridecodebin elements로 생성합니다. uri로 지정한 파일을 raw audio와 video stream으로 변환할 때 사용합니다. audioconvert elements는 raw audio 데이터를 다른 format으로 변환하는 데 사용합니다. audioresample을 통해 raw audio buffer를 resampling 해서 품질을 높입니다. 마지막으로 autoaudiosink elements로 생성합니다. 여기서 sink, source를 제외한 두 elements들이 filter 역할을 하게 됩니다.

data.source = gst_element_factory_make ("uridecodebin", "source");

data.convert = gst_element_factory_make ("audioconvert", "convert");

data.resample = gst_element_factory_make ("audioresample", "resample");

data.sink = gst_element_factory_make ("autoaudiosink", "sink");

이전 튜토리얼에서 playbin을 통해 uri을 setting 해줬고 이 예제에서는 source elements에 uri property 값을 set 해주게 됩니다.

/* Set the URI to play */

g_object_set (data.source, "uri", "https://www.freedesktop.org/software/gstreamer-sdk/data/media/sintel_trailer-480p.webm", NULL);다음으로 이 예제에서 가장 중요하다고 생각하는 GSignal 관련 내용입니다. 내부 동작 방식은 다르겠지만 Qt에서 제공하는 signal-slot과 비슷하게 사용하면 될 거 같습니다.

/* Connect to the pad-added signal */

g_signal_connect (data.source, "pad-added", G_CALLBACK (pad_added_handler), &data);elements에서 signal이 발생했을 때 호출할 function을 넘겨주고 그 함수에서 사용할 데이터를 넘겨주게 됩니다.

source elements에 새 pad가 추가될 때 호출이 됩니다. 이 중 raw audio 형식만 골라 audioconvert elements의 sink pad와 link 시켜주는 함수입니다.

/* This function will be called by the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *new_pad, CustomData *data) {

GstPad *sink_pad = gst_element_get_static_pad (data->convert, "sink");

GstPadLinkReturn ret;

GstCaps *new_pad_caps = NULL;

GstStructure *new_pad_struct = NULL;

const gchar *new_pad_type = NULL;

g_print ("Received new pad '%s' from '%s':\n", GST_PAD_NAME (new_pad), GST_ELEMENT_NAME (src));

/* If our converter is already linked, we have nothing to do here */

if (gst_pad_is_linked (sink_pad)) {

g_print ("We are already linked. Ignoring.\n");

goto exit;

}

/* Check the new pad's type */

new_pad_caps = gst_pad_get_current_caps (new_pad);

new_pad_struct = gst_caps_get_structure (new_pad_caps, 0);

new_pad_type = gst_structure_get_name (new_pad_struct);

if (!g_str_has_prefix (new_pad_type, "audio/x-raw")) {

g_print ("It has type '%s' which is not raw audio. Ignoring.\n", new_pad_type);

goto exit;

}

/* Attempt the link */

ret = gst_pad_link (new_pad, sink_pad);

if (GST_PAD_LINK_FAILED (ret)) {

g_print ("Type is '%s' but link failed.\n", new_pad_type);

} else {

g_print ("Link succeeded (type '%s').\n", new_pad_type);

}

exit:

/* Unreference the new pad's caps, if we got them */

if (new_pad_caps != NULL)

gst_caps_unref (new_pad_caps);

/* Unreference the sink pad */

gst_object_unref (sink_pad);

}이 코드를 실행하면 튜토리얼에서 진행했던 동영상의 음성만 들리는 것을 확인할 수 있습니다. 그리고 출력 창에는 아래처럼 디버깅 메시지가 찍히게 됩니다.

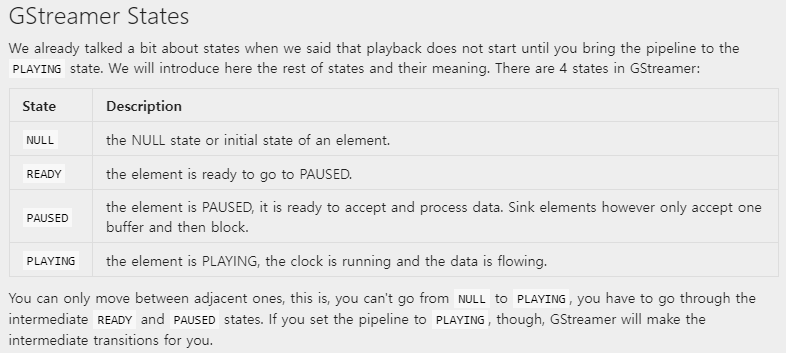

Pipeline state 관련 내용은 아래 표를 참고하시면 됩니다.

'Programming > Gstreamer' 카테고리의 다른 글

| [Gstreamer/Qt] Gstreamer(6) - Pad template (0) | 2023.03.23 |

|---|---|

| [Gstreamer/Qt] Gstreamer(5) - player 예제 (0) | 2023.03.22 |

| [Gstreamer/Qt] Gstreamer(4) - query (0) | 2023.03.21 |

| [Gstreamer/Qt] Gstreamer(2) - Element, pipeline (0) | 2023.03.20 |

| [Gstreamer/Qt] Gstreamer(1) - 환경 세팅 및 기초 (0) | 2023.03.17 |